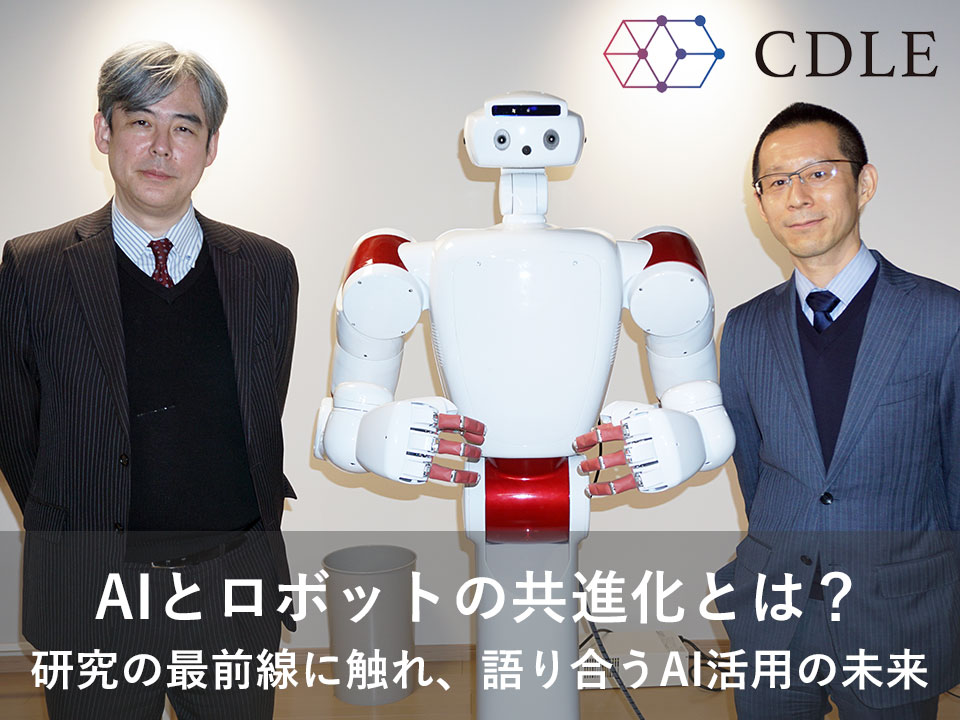

尾形哲也 教授(JDLA理事)×鈴木淳哉 氏(CDLEメンバー) 対談レポート

協力:早稲田大学 尾形哲也研究室

JDLAが実施するG検定、E資格の合格者が加入する日本最大のAIコミュニティCDLE(Community of Deep Learning Evangelists)メンバーの鈴木淳哉氏が、2022年1月、「JDLA Presents CDLE HACKATHON 2020」の予測性能部門において準優勝の副賞として、早稲田大学の尾形哲也研究室を訪問。JDLA理事である尾形哲也教授(早稲田大学 基幹理工学部 表現工学科 教授)が取り組む「AIREC」や「HATSUKI」といったAI×ロボットの最先端の研究プロジェクトを見学した後、対談を行いました。

※「JDLA Presents CDLE HACKATHON 2020」の予測性能部門準優勝の副賞は当初会食を予定していましたが、新型コロナウイルスの影響を考慮し、形式を変更し実施しています。

JDLA理事 / 早稲田大学 基幹理工学部表現工学科 教授

尾形 哲也 氏

1993年、早稲田大学理工学部機械工学科卒。同大学同学部助手、ヒューマノイド研究所 客員講師・客員准教授、理化学研究所脳科学総合研究センター研究員、京都大学大学院 情報学研究科 知識情報学専攻 講師・准教授などを経て2012年より現職。日本ロボット学会理事、人工知能学会理事、計測自動制御学会理事等を歴任。2017年からは産業技術総合研究所 人工知能研究センター特定フェローも務める。(株)エクサウィザーズ技術顧問を務める。

CDLEメンバー

鈴木 淳哉 氏

2019 年にG検定、E資格をともに取得。各種データ分析コンテストに参画しながら、Pythonや機械学習、統計学など情報を、ブログやTwitterで発信中。

「JDLA Presents CDLE HACKATHON 2020」予測性能部門 準優勝

「JDLA Presents CDLE HACKATHON 2021」企業賞

[その他データ分析サイトコンテスト実績]ProbSpace 総合1位(金5、銀2、銅2)、Nishika 総合13位(金1、銅2)、SIGNATE 銅1、Kaggle 銅1

―今日はCDLE HACKATHON 2020の副賞ということでこの席を設けさせていただきました。鈴木さん、少し時間が経ってしまいましたが改めてCDLE HACKATHON 2020に参加された経緯を教えてください。

鈴木:AIや機械学習に興味を持った際に、G検定、E資格のことを知りました。普段の仕事はAIとは全く関係ないのですが、私は資格を取得することが好きなのもあり、G検定とE資格に挑戦しました。その二つに合格した後、CDLE HACKATHONのことをご案内いただき、面白そうだと感じたので参加させていただきました。私は宇宙が好きなので、CDLE HACKATHONの衛星画像からAIで24時間後の気象状況を予測する課題は、楽しみながら取り組むことができました。

尾形:参加された皆さんの取り組みが非常に素晴らしく、かなり厳しい競争になりましたね。いろいろな方が様々なAIモデルを使われていたのも興味深く思いました。鈴木さんが使われたAIモデルは、どのようにして採用を決めたのですか。

鈴木:ほかのコンペティションでも使われているモデルを参考に、取り入れられそうなものを探しました。評価関数を今回の目的に合うように調整し、いくつかのモデルを組み合わせて結果を得ました。

尾形:準優勝を獲得されたということで、既にかなりの成果を残されている訳ですが、今後どのような取り組みを考えていらっしゃいますか。

鈴木:現在、ProbSpaceやNishikaなど、予測課題がある様々なコンペティションに参加させていただいています。2021年12月には、CDLE HACKATHON 2021にもチームで参加し、企業賞をいただきました。いろいろなコンペに参加するうちに、「コンペだけでなく、実際の社会貢献に携わることができないか」と考えるようになりまして、様々な情報発信を始めているところです。

尾形:本業をやられている中で、AIに関しても様々な取り組みをされている訳ですよね。本当に凄いです。副業が認められているお仕事なのですか。

鈴木:はい、副業が認められているので、時間をやりくりして楽しく取り組んでいます。ただ、可能であれば本業にもAIを生かしたいという気持ちが強くなってきています。会社にコンペの結果は報告していますが、実業務に生かすための評価としては足らず、研究開発に携わって実績を残す必要があるのを感じています。

尾形:そこまでのお気持ちがあって、いろいろ行動をされていらっしゃるのであれば、やりようはあるように感じますね。大学の研究室に研究員として入ることができる可能性もあるのではないかと感じます。

鈴木:研究員をやらせていただける機会があるなら是非お願いしたいですね。大学の修士課程は修了しているのですが、博士課程には行っていないので、機会があれば博士課程に進みたいですね。

人間とロボットが共進化する未来を目指して

―近年は様々なサービスにAIが取り入れられたり、AIエンジンを搭載した家電が増えていたりと、生活のいろいろな部分にAIが入り込むようになりました。周辺環境に入るAIと、尾形先生が研究されているロボットのAIには違いがあるように感じるのですがいかがでしょうか。

尾形:私がやっている研究は、スマートフォンのようなものだと言えます。カメラやゲーム機、辞書など、それぞれ専用のものが存在していましたが、今はそれらがスマホに集約されています。スマホが登場したころは、ゲームもやりにくかったし、音も悪いし、といろいろな欠点がありましたが、今では専用機にも劣らないくらいの状況になってきました。

スマホのように、「専用のものを汎用にまとめる」というのが私がロボット×AIで取り組もうとしていることです。それが人型である必要があるのかというところはまだ分からないのですが、現状では多くの専用ロボットが作られている中で、汎用のロボットを研究する価値はあると思っています。例えば、移動という機能をロボットが備えているのであれば、配膳や介護、警備も可能だろうし、アームがあるなら先ほどご覧いただいた料理だったり、ものの組み立てもできるでしょう。こういったことはハードウエアの汎用性を高めることができれば、ディープラーニングの重み付けをするだけで実現可能だと考えています。

今取り組んでいるムーンショット計画は、国が全体で年間1,000億円を出して取り組んでいるプロジェクトです。いくつかプロジェクトがあり、その1つとしてロボットのプロジェクトがありまして、目標を「2050年までに、AIとロボットの共進化により、自ら学習・行動し人と共生するロボットを実現」としています。私としては、その手前の2030年にはある程度使い回しができる汎用ロボットが作れるのではないかと感じています。

―汎用ロボットを作る場合、AIも汎用になるのでしょうか。それとも専用のAIエンジンを複数搭載して切り替えて使うのでしょうか。

尾形:AIモデルの切り替えで対応したほうが簡単なので、最初はそうなると思います。ただ、例えば配膳と介護は移動のアルゴリズムは同じなので、そこは共有できるはずです。共有できるところは共有し、それ以外の部分は学習して目的によってAIエンジンの重み付けを変えれば、将来的には一つのAIエンジンで様々なことに対応できるだろうと思っています。

人間はメンタルが1つですよね。そのメンタルで、汎用的にいろいろなものに対応します。AIがそれを模すのであれば、AIエンジンも1つの方がいいことになります。ですから、いろいろなタスクをAIエンジンに経験させて、汎用化する取り組みを続けていけたら、と考えています。

内閣府ムーンショット計画で掲げている「人とロボットの共生、共進化」はとても難しいことなんです。人間はお互いのことを読み取って学習し、コミュニケーションがリッチになっていきますが、人間とロボットの場合、現状では人間がロボットに合わせてしまっています。共進化とは、人とロボットの間でも、人間同士のような関係性を築けるようにする、ということを意味しています。

これまでAIは、データと解釈を1対1でマッピングすればいい、という考えに基づいて作られてきましたが、それを見直すべきなのではないかと考えています。

例えば、ここにペットボトルに入った水があります。これを水と見るか、ペットボトルと見るか、ただのゴミと見るかは、見ている人の主観が関係します。飲みたければ水だと思いますよね。つまり、見ている人のコンテキストによるのです。解釈が多義的にある中で、目的によって行動が決まっています。行動するということは、身体を持っています。私が人型のロボットにこだわっているのは、ロボット自らが人間に近い身体を持つことで、人間のコンテキストや解釈を読み取り、共進化できる可能性が高まると考えているからなんです。

―HATSUKIについても教えていただけますでしょうか。

HATSUKIは、アニメやCGを作るために取り込まれているデータを、ロボットの動作の学習に使うことも目的に開発したものです。その派生的な使い方として、VTuberに利用されているようなアニメーションの動作をリアルタイムにロボットに反映する、という研究を学生がしています。その学生はHATSUKIを使った起業も考えていて、早稲田大学のベンチャー支援プログラムを利用して取り組みを進めています。アカデミックなところとは少し離れてしまいますが、彼はHATSUKIのビジネス展開の可能性をいろいろ検討していますね。

JDLAを異分野が繋がる場に

尾形:JDLAが「学会」ではなく「協会」を名乗っているのには、アカデミアだけでなく様々な方に広く参加していただきたいという考えがあるためです。経営者の方や、ビジネスの現場にいらっしゃる方に関わっていただくことで広がりが出ると思っています。そもそもAIは「AI×○○」という組み合わせが大事な分野です。例えば、画像処理や自然言語の分野では大きな成果が上がっています。私で言えばこれがロボットに当たります。まさにこれから、大きな成果が出ると思っています。このように様々な分野で高い専門性をお持ちの方にご参加いただくのが、とても重要だと考えています。

鈴木:セキュリティも非常に重要になってきますよね。

尾形:例えば、AIを取り入れた自動車やロボットなどが事故を起こしたり、AIが集めた情報が漏えいしたりした場合などに、誰が責任を取るのかという問題がありますよね。「AIを使えば市場規模が大きい新たなビジネスが確実に生み出せる」という分野があった場合に、データ活用やセキュリティ、責任所在などの問題で踏み出せない、というケースもあるのではないかとも思います。そうしたことを考えると、AI×法律、AI×政治も重要になってくるので、やはり他の分野の方に加わっていただく必要があります。

私が主催するAIロボット研究所でも、半分は文系の方に入っていただいていますし、内閣府ムーンショット計画にも理工系以外の方に加わっていただいています。JDLAのG検定にも「学部を越えていろいろな方に参加して欲しい」という思いを込めていますし、そういう意味でも鈴木さんに目立っていただくことはとても大事だなと感じています。

―鈴木さんのように、G検定やE資格を取得して、いろいろなことに取り組みたいという方は沢山いらっしゃると思います。尾形先生はどんなことを期待していらっしゃいますか。

尾形:先ほどの内容と重なってしまいますが、皆さんが持っていらっしゃるバックグラウンドがどうAIに生きるか、繋がっていくかということに興味を持っています。G検定を取得できるレベルであれば、お互いの興味で繋がることができると思いますし、E資格であれば共同開発が可能です。いろいろな人が集まって新しいものを作るのは、学問から見ても大変重要です。AIは異分野を繋げる力があると思いますので、それを繋げる場所としてJDLAや検定、資格が機能していけばと思います。

★記事にてご紹介した早稲田大学尾形研究室のプロジェクトについて

・Cutieroid Project 「HATSUKI」

早稲田大学発、人工知能(AI)×ロボティクス技術×アニメ文化の融合により、Autonomous Humanoid Figure(AHF:自律人型フィギュア)を開発することを目標としたプロジェクト

https://www.cutieroid.com/AboutHatsuki

・AI-driven Robot for Embrace and Care「AIREC」

【ムーンショット型研究開発事業:目標3】2050年までに、AIとロボットの共進化により、自ら学習・行動し人と共生するロボットの実現を目指す

https://airec-waseda.jp/